En este artículo vamos a explicar como crear un workflow básico para generar imágenes a través de ComfyUI. Para los que no la conozcáis aún, se trata de una de las interfaces más utilizadas, que podéis instalar en vuestro ordenador y ejecutar diferentes nodos de inteligencia artificial generativa para la creación de imágenes o animaciones.

Para instalar ComfyUI solo tenéis que acceder a su perfil de github y descargar su versión portable.

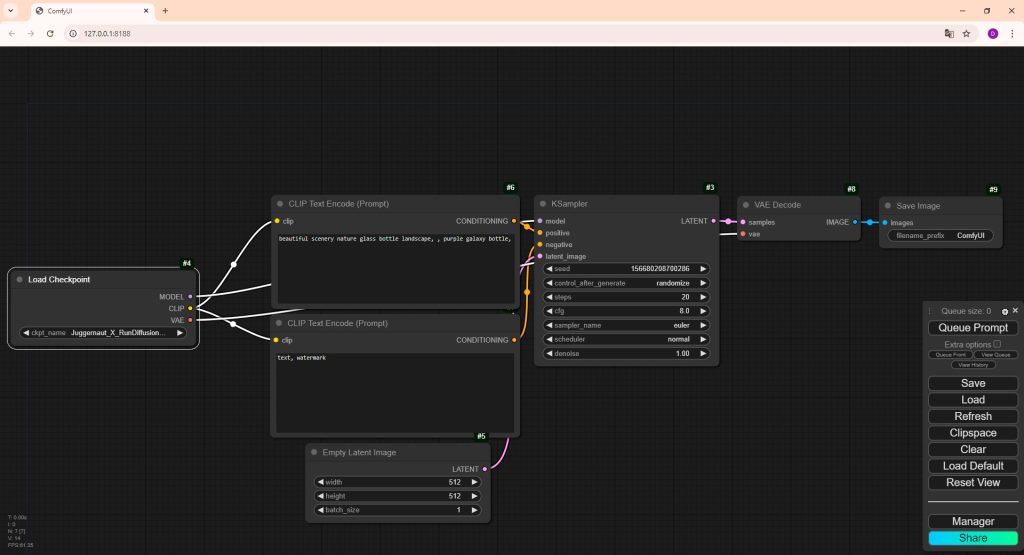

Una vez instalado pulsáis sobre la opción para cargar el flujo de trabajo por defecto mediante el que se os cargará los nodos necesarios para empezar a generar imágenes.

Nodos esenciales para generar imágenes en ComfyUI

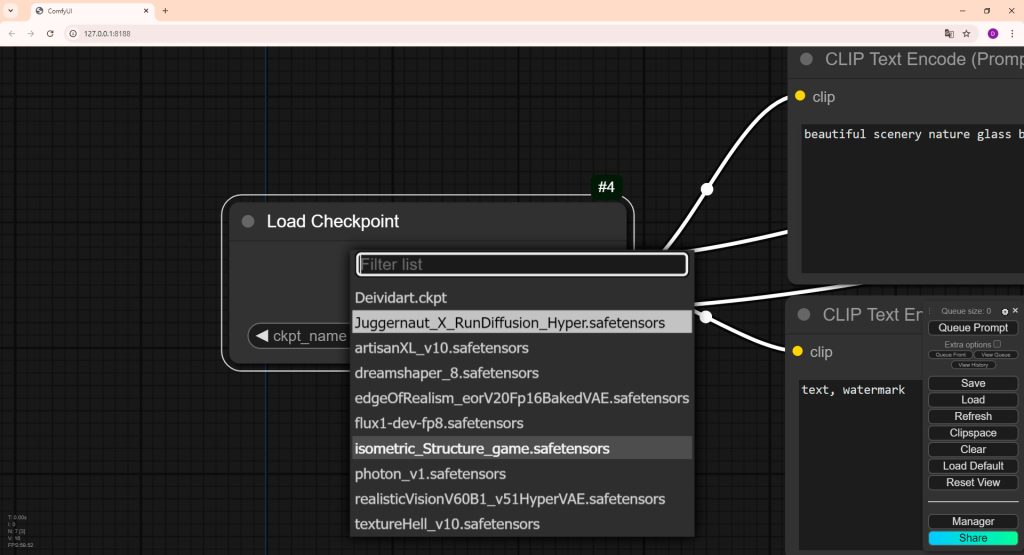

Cargar modelo

Load Checkpoint es el nodo que nos permite cargar el modelo que previamente hemos descargado en la carpeta que ComfyUI nos habilita para ello. Podemos almacenar un sin fin de modelos diferentes en función de la imagen que queremos conseguir, solo tenemos que descargarlos desde sitios webs como Civitai.

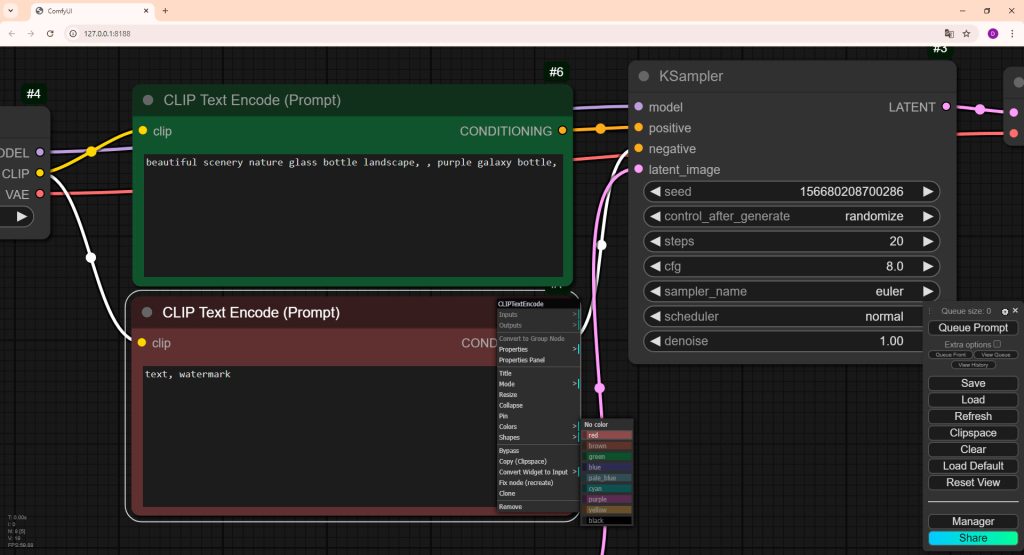

Prompt negativo y positivo

Para introducir el prompt debemos de cargar el nodo Clip text encode (prompt). Es recomendable tener 2 nodos de este tipo para escribir en nodo positivo y negativo.

Una metodología muy utilizada es cambiar a color verde el nodo positivo y de color rojo el negativo, de esta forma los tendremos localizados en todo momento. Para ello solo tenemos que pulsar click derecho sobre el nodo y buscar la opción «Colors»

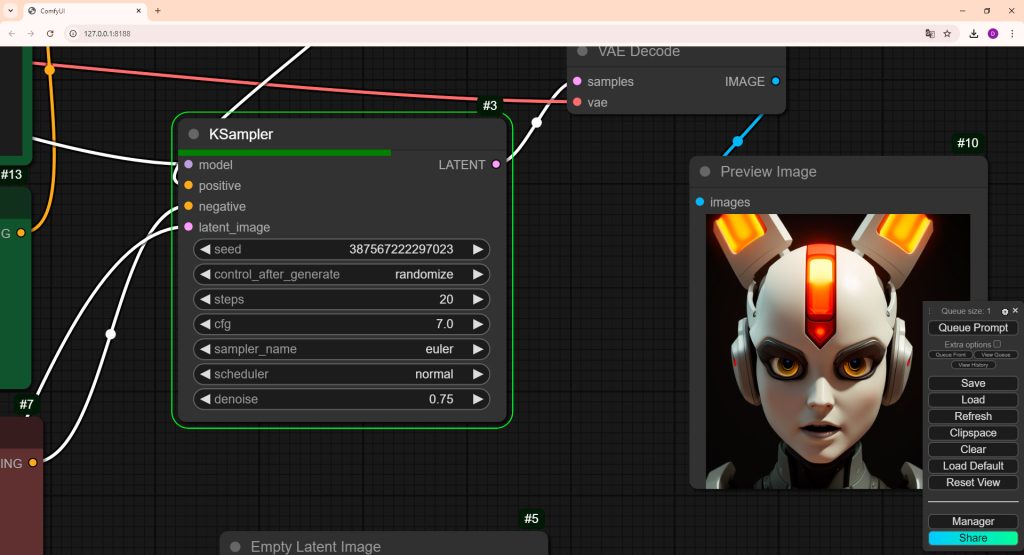

Ksampler

Este nodo es como un «pintor» que, paso a paso, va dibujando una imagen a partir de una idea o boceto inicial (que es una versión muy borrosa o abstracta de la imagen). A medida que avanza, va refinando los detalles hasta que finalmente termina la imagen completa y nítida.

Parámetros KSampler

En este nodo conectaremos los nodos anteriores (modelo y prompts) junto a la imagen latente que veremos a continuación. Además podremos ajustar diferentes parámetros para ajustar el resultado de la imagen creada por la inteligencia artificial.

Seed (Semilla): Cada número de semilla genera una imagen diferente a partir de la misma idea original. Si usas la misma semilla, obtendrás la misma imagen cada vez que la generes. Es muy útil si quieres reproducir una imagen exacta guardando el número de semilla, o cambiar la imagen generada al cambiar de forma aleatoria la semilla.

Control after generate: Permite que, después de generar la imagen final, se realicen ajustes extra, como aplicar transformaciones basadas en controladores específicos (como ControlNet, máscaras, o guías adicionales). Si necesitas aplicar efectos o guías adicionales que se basen en la imagen ya generada, puedes usar este parámetro para realizar ese ajuste. En el caso que estamos mostrando no es necesario cambiar este parámetro.

Steps: Son los «golpes de pincel» que el pintor va dando para refinar la imagen. Cuantos más pasos, más detallada y precisa será la imagen, aunque el proceso será más lento.

CFG (Guidance Scale): Este es como un «consejero» que le dice al pintor hasta que punto debe ajustarse a la idea original (por ejemplo, el prompt o boceto). Un valor bajo significa que el pintor tiene más libertad para crear algo nuevo, mientras que un valor alto le obliga a seguir más estrictamente las instrucciones.

Sampler. Este parámetro define el «estilo de trabajo» del pintor, es decir, la técnica (algoritmo) que usará para ir refinando la imagen. Los más utilizados son Euler, LMS o DDIM. Algunas técnicas pueden ser más rápidas, otras pueden ser más detalladas y ralentizar el proceso.

Scheduler: Imagina que estás creando una imagen empezando desde una masa de puntos borrosos (ruido). El proceso del scheduler es como seguir un plan o calendario que determina qué tanto ruido eliminar en cada etapa. Si se hace de manera muy rápida o de manera muy lenta, el resultado final puede ser diferente. El scheduler controla este ritmo y estilo de refinamiento.

Diferentes schedulers pueden producir resultados ligeramente diferentes en cuanto a estilo, detalle, o velocidad del proceso. Algunos ejemplos de schedulers comunes son:

- DDIM (Denoising Diffusion Implicit Models): Ofrece un proceso más rápido y permite generar imágenes con menos pasos, a menudo sin sacrificar demasiada calidad.

- Euler y Euler Ancestral: Son populares por su equilibrio entre velocidad y calidad.

- LMS (Laplacian Pyramid Sampling): Tiende a ser más estable en ciertas situaciones y puede producir resultados más consistentes.

Denoise: El proceso de generación de la imagen es como tallar una escultura a partir de un bloque de piedra. El parámetro denoise controla cuántas partes del bloque de piedra (ruido) quieres quitar para revelar la forma (imagen final).

Si lo que quieres es una imagen que cambie mucho y se refine completamente a partir de ruido, usa un denoise más alto (cercano a 1.0). Si prefieres mantener más características del input o hacer cambios suaves, usa un denoise más bajo.

Por ejemplo en un flujo de imagen a imagen, este valor determinará cuanto se parecerá la imagen original al resultado final.

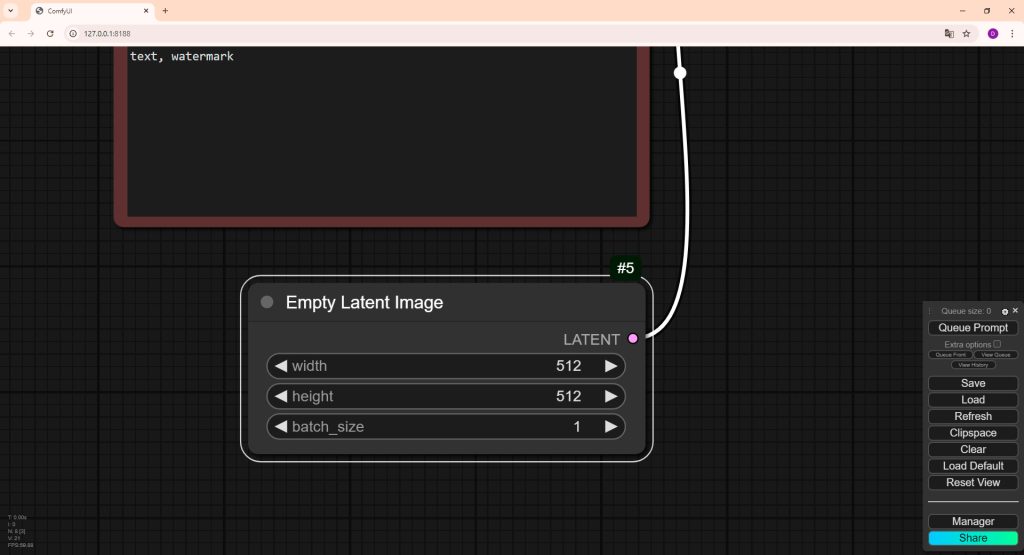

Imagen latente vacía

El nodo «Empty Latente Image» crea una representación intermedia de la imagen que se encuentra en un espacio latente que es donde se almacena la información de la imagen condensada en un formato que el modelo puede manipular.

En este nodo establecemos el número de píxeles de ancho y alto de cada imagen que queremos generar y la cantidad (batch_size) cada vez que ejecutemos el workflow que estamos generando . Posteriormente, otros nodos pueden operar sobre este, aplicándole transformaciones, generando nuevas versiones de la imagen, o reconvertirlo al espacio de píxeles visibles.

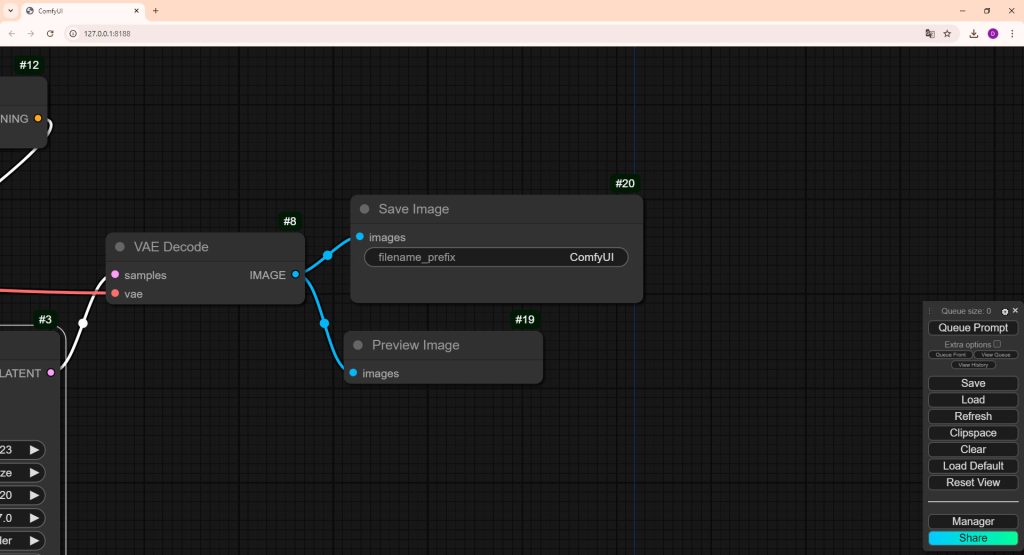

VAE Decode

VAE Decode es el paso final que traduce una imagen latente en una imagen completa y visualizable. Para ello debemos conectar el archivo VAE que generalmente viene por defecto con el modelo que estamos trabajando y la imagen latente a partir del nodo Ksampler.

Previsualizar y guardar imagen

Una vez tenemos nuestra imagen en el nodo VAE Decode solo tenemos que conectarlo a un nodo que nos permita o bien visualizar el resultado o guardarlo directamente en la carpeta «output» de ComfyUI.

Con estos nodos en la mesa de trabajo de ComfyUI y bien conectados lo tendremos todo preparado para empezar a generar imágenes pulsando en la opción Queue Prompt. Una vez pulsado podremos ir viendo en que nodo se encuentra el proceso, a partir de aquí solo queda hacer iteraciones, cambiar parámetros, modelos y ajustar los prompts hasta conseguir la imagen que mejor se ajuste a lo que necesitemos.

Categoría/s: Arte digital

Matte painting – Star wars

Matte painting – Star wars Matte painting – Acantilado

Matte painting – Acantilado Matte painting – templo

Matte painting – templo

Deja una respuesta